L’industrie micro-électronique arrive-t-elle à maturité ?,

Comment Intel devint hégémonique.

L’évolution et l’avenir de l’industrie américaine font l’objet d’analyses nombreuses et contradictoires ; certains auteurs, comme Emmanuel Todd dans Après l’Empire : Essai sur la décomposition du système américain, en infèrent le déclin de phénomènes tels que le déficit commercial abyssal des États-Unis, le déplacement vers l’Asie des grands centres de production industrielle et la baisse du niveau de formation des jeunes générations. Des études comme celle de la Task Force on the Future of American Innovation, par exemple, qui regroupe de grandes entreprises (Microsoft, Intel...) et des sociétés savantes (AMS, ACM) , apportent des arguments à l’appui de cette thèse.

Sans me prononcer sur ce sujet en général, pour lequel je n’aurais guère de compétence, je voudrais donner quelques éléments de réflexion au sujet des industries électronique et informatique américaines, que je connais mieux.

Mes archives ont restitué quelques chiffres [1]

relatifs aux industries informatique (logiciel et services compris) et électronique à la fin des années 1980 et au début des années 1990 :

L’évolution de Hewlett-Packard est impressionnante, mais il faut préciser que HP a racheté Compaq, qui lui-même venait d’acheter Digital Equipment...

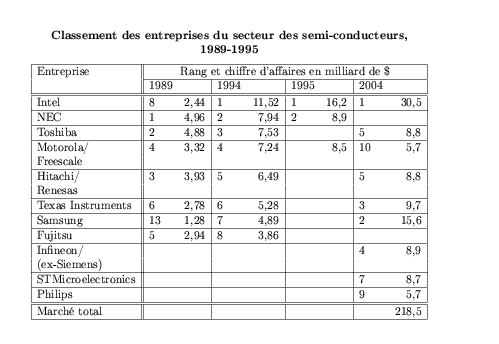

La vague japonaise des années 1980

Que nous suggèrent les chiffres de 1989 (à l’époque c’était bien cela que j’en pensais, et je n’étais pas le seul) ? L’ascension irrésistible de l’industrie électronique et informatique japonaise, dont la vague submergeait tout sauf IBM, qui lui-même vacillait encore en 1993. Intel, l’inventeur du micro-processeur, devenait une entreprise marginale qui s’enfonçait dans les profondeurs du classement. L’ordinateur que j’avais alors sur mon bureau était une station de travail Sony sous un excellent Unix BSD.

Le sursaut américain des années 1990 dans l’électronique

Que nous montre 1995 ? L’industrie américaine s’est ressaisie, et cette remontée n’a fait que se confirmer depuis dix ans. En fait, l’événement le plus significatif apparaît sur le second tableau, c’est la remontée d’Intel.

Comment l’expliquer ? Il faut pour cela remonter un peu dans l’histoire de l’industrie des semi-conducteurs, de l’industrie informatique, et de leurs relations mutuelles.

Naissance de la micro-informatique

C’est en 1981 qu’IBM a créé une nouvelle industrie en lançant son micro-ordinateur PC, pour lequel il avait fait le choix du micro-processeur Intel 8088, au détriment du Motorola 68000, techniquement bien supérieur. On aurait donc pu s’attendre à une croissance d’Intel plus importante à partir de cette date. Mais au début de la décennie 1980 les firmes de semi-conducteurs sont petites et faibles face à leurs clients de l’industrie informatique, qui dépendent moins d’elles qu’aujourd’hui. En effet, si un ordinateur de l’an 2005 est fondamentalement un micro-processeur entouré de mémoire et de périphériques, en 1981 ce n’était le cas que pour les tout petits ordinateurs, les machines sérieuses, gros IBM ou VAX de chez Digital Equipment, étaient réalisées en logique discrète, c’est-à-dire que des composants élémentaires étaient disposés sur des cartes logiques et câblés. Ces composants étaient déjà relativement intégrés, mais ils n’étaient pas des processeurs complets. L’architecte du système était donc IBM ou Digital Equipment, et pas le fabricant de composants. Ainsi en 1978, l’unité centrale du VAX/11-780 de Digital Equipment se composait de 27 cartes au format 7U x 9U, soit 31cm sur 40 cm (merci à Daniel Clar de Supelec pour ces précisions), remplies de composants plus ou moins complexes ; sa puissance de calcul était à peu près celle d’un Palm Pilot d’aujourd’hui. De fait IBM et Digital Equipment fabriquaient eux-mêmes leurs composants, qui étaient beaucoup moins complexes qu’aujourd’hui, et ces firmes, ainsi que Hewlett-Packard, deviendront d’ailleurs dès la fin des années 1980 d’excellents concepteurs de micro-processeurs [2].

Naissance et abandon de la politique de seconde source

Bref, en 1981 les fabricants de semi-conducteurs étaient à la merci de leurs clients fabricants d’ordinateurs, et justement IBM exigea qu’Intel ne soit pas le seul fabricant du microprocesseur 8088, pièce maîtresse du PC. Intel concéda donc des accords dits de seconde source à d’autres industriels, notamment AMD, NEC, etc. Ces accords de seconde source furent à l’origine d’une concurrence fructueuse et Intel ne fut de loin pas le seul à bénéficier de la propagation de sa technologie, ce qui lui causa une certaine amertume. Aussi lors du lancement de son modèle 386 en 1986 Intel annonça-t-il la fin des accords de seconde source, ce qui provoqua quelques procès, dont un gagné en 1989 par AMD. Ces procès ne furent que des combats d’arrière-garde, et quelques années plus tard Intel avait repris le contrôle de sa propriété industrielle.

Si Intel a pu abandonner sa politique de seconde source, c’est qu’entre temps le rapport de forces s’était déplacé en sa faveur, puisqu’il disposait désormais d’une position de monopole dans le domaine de la conception de processeurs de PC.

Comment l’industrie américaine a-t-elle repris le contrôle ?

Outre l’abandon évoqué ci-dessus de la politique de seconde source, qui coupait pour les entreprises japonaises le robinet de l’innovation en conception de processeurs, l’industrie américaine avait pris d’autres mesures pour enrayer son déclin. Les principaux industriels du secteur avaient créé dès 1977 la

Semiconductor Industry Association, qui elle-même créa en 1982, à l’initiative de Bob Noyce, une filiale destinée à organiser et à financer la recherche pré-compétitive, Semiconductor Research Corp. (SRC). Les statuts de SRC prévoyaient explicitement le refus d’accepter des membres non-américains.

La SIA et SRC ne furent en aucun cas des organisations potiches. Elles reçurent des financements importants en provenance des industriels et des pouvoirs publics, notamment du Department of Defense (DoD), et s’engagèrent dans une politique de collaboration active avec les Universités ; ces actions eurent pour fruit de nombreuses innovations techniques et le redressement de la courbe de progrès de l’industrie américaine, innovations et progrès dont le bénéfice était explicitement réservé aux entreprises américaines.

La leçon que l’on peut tirer du redressement américain et du coup d’arrêt porté à la vague japonaise qui semblait irrésistible, c’est que les Japonais ne furent pas capables de développer leur industrie avec leurs propres facteurs d’innovation, ce qui révélait leur dépendance à l’égard de la propriété intellectuelle américaine.

Mais de quoi au juste se compose la propriété intellectuelle incorporée à un micro-processeur ?

Embryogenèse et anatomie d’un micro-processeur

Pour fabriquer un micro-processeur utilisable il faut disposer des éléments suivants :

– la conception du circuit ;

– l’infrastructure de fabrication ;

– un système d’exploitation qui permette sa mise en œuvre.

Examinons successivement la teneur de chacun.

- Conception du circuit : au début des années 1980, le processeur 68000 de Motorola était nommé ainsi parce qu’il comportait à peu près 68000 portes logiques. La porte est l’élément de base du processeur, vous pourrez en lire ici l’explication.

Le processeur est réalisé par projection d’électrons sur un support de silicium, ou par un procédé optique, par un faisceau de rayons ultra-violets (ici un document, et là un autre qui expliquent cela). Les machines qui les fabriquent opèrent comme des tables à dessin automatiques qui produiraient des dessins microscopiques : une porte d’un processeur moderne a une dimension de l’ordre de 0,065 microns (mise à jour 2011 : 32 nanomètres). Les processeurs contemporains ont de l’ordre de 50 millions de portes, l’Itanium 2 d’Intel comporte 410 millions de transistors (mise à jour 2011 : 1 milliard de portes). Concevoir à la main un tel circuit n’est pas envisageable : on utilise un langage de description (le plus connu s’appelle VHDL), dont les instructions sont traduites par le logiciel d’aide à la conception vers une base de données de dessins. Les entreprises qui réalisent de tels logiciels se comptent sur les doigts de la main. La conception d’un processeur entièrement nouveau, comme l’Itanium, représente sept à huit ans de travail pour 100 à 200 ingénieurs. Maîtriser un tel processus ne s’improvise pas du jour au lendemain. - Infrastructure de fabrication : une usine qui fabrique des processeurs coûte 4 milliards de dollars (en 2011 : 8) ; la machine de base de cette usine (nommée stepper) est un appareil photo-lithographique qui transfère l’image du masque du circuit, issu de l’étape de conception, sur une petite portion de la surface du wafer, ou galette, de silicium. Les progrès dans la miniaturisation des processeurs dépendent pour une grande part des progrès dans la réalisation de lentilles en verre de très grande qualité pour ce type d’appareil. Cet engin coûte 15 millions de dollars. La conception même de telles machines n’est maîtrisée que par un tout petit nombre d’entreprises.

- Système d’exploitation : sans système d’exploitation, un processeur est aussi inutilisable qu’un bout de ferraille. J’ai écrit sur le sujet un livre disponible en ligne ici. Qu’il suffise ici de dire qu’un système d’exploitation muni de son interface graphique et de tous les accessoires convenables comporte de l’ordre de 30 millions d’instructions de programme, et qu’il faut, là aussi, sept à huit ans à 100 à 200 ingénieurs pour le concevoir et le réaliser. Il n’y a plus en Europe d’activité de conception de système d’exploitation général, hormis chez les membres de la communauté des systèmes d’exploitation libres (Linux, xBSD).

De ce qui précède on voit que la maîtrise industrielle dans le domaine des industries électronique et informatique repose sur l’appropriation de démarches technologiques extrêmement complexes et très peu répandues. Il s’agit bien de technologie, et pas seulement de technique, parce que la réalisation industrielle est étroitement liée à la démarche théorique et au progrès de la recherche fondamentale et appliquée.

Le sursaut américain des années 1990 dans l’informatique

Tout au long des années 1970 et 1980 le monde de la construction d’ordinateurs, dominé par IBM, vivait une concurrence acharnée stimulée par les fabricants d’ordinateurs compatibles avec les grands systèmes IBM (série 370 et 390). Ce marché ouvert était né d’une décision de la cour suprême des États-Unis, qui imposa à IBM de facturer à part logiciel et matériel (ce fut l’unbundling, voir ici les détails, et là une analyse économique de Michel Volle). D’autres procès contraignirent IBM à publier les spécifications des interfaces de ses systèmes, afin de permettre à ses concurrents d’y connecter leurs propres sous-systèmes, comme par exemple des disques ou des imprimantes.

Grâce à cet arsenal juridique, un industriel pouvait construire un ordinateur compatible IBM et le vendre en indiquant à son client d’acheter le système d’exploitation, c’est-à-dire la partie la plus longue à développer et la plus complexe, chez IBM. Il était aussi possible de vendre des périphériques (disques, dérouleurs de bandes, imprimantes) compatibles à des clients d’IBM.

Sur ce marché du compatible (plug to plug) beaucoup de sociétés étaient soit des sociétés japonaises, soit de petites sociétés américaines adossées à l’infrastructure industrielle de leur associé japonais. L’exemple emblématique de cette situation était celui d’Amdahl, fondée par Gene Amdahl, le créateur de l’architecture matérielle de l’IBM 360, dont la société est maintenant un département de Fujitsu.

IBM avait essuyé un échec sur le terrain de la législation anti-trust, mais ne s’avouait pas vaincu. Petit à petit, ses ingénieurs et ses avocats élaborèrent des moyens subtils de contourner les décisions juridiques défavorables sans donner prise aux avocats de la partie adverse, mais en empêchant ses ingénieurs de profiter de son système d’exploitation et de ses interfaces. Aujourd’hui l’industrie du compatible IBM est réduite à la portion congrue... non sans avoir entraîné dans sa chute les tarifs d’IBM, qui a dû aligner ses prix sur ceux de la concurrence. C’est en l’an 2000 qu’Amdahl/Fujitsu et Hitachi ont abandonné le terrain, rendant à IBM son monopole sur un marché encore très lucratif, et qui n’est pas près de s’éteindre.

La loi Sarbanes-Oxley va-t-elle abattre le dynamisme américain ?

Vous pourrez lire sur le site de VLSI Research un article où son président G. Dan Hutcheson fait une analyse très pessimiste des perspectives de l’économie américaine postérieures à l’affaire Enron. On sait qu’après la succession de scandales financiers qui ont suivi l’éclatement de la bulle Internet le Congrès américain a promulgué en 2002 une loi dite loi Sarbanes-Oxley

qui impose aux entreprises qui font appel au capital public (c’est-à-dire cotées en bourse) toute une série de règles comptables et administratives destinées à assurer la traçabilité de leurs opérations financières, afin que les actionnaires ne courent plus le risque de voir leurs actions partir en fumée après une déconfiture que des comptes truqués n’auraient pas permis de prévoir, cependant que les dirigeants initiés auraient revendu à temps leurs stock-options pour se retirer sur leur yacht aux îles Cayman... Notons que tous les grands pays occidentaux se sont rapidement dotés de lois analogues, en France c’est la loi sur la sécurité financière (LSF) du 1er août 2003, qui ne concerne pas seulement les sociétés cotées, mais toutes les sociétés anonymes, complétée par le dispositif réglementaire européen « Bâle 2 » de 2004.

Hutcheson retient les points suivants :

- la quasi-disparition des stock-options prive les entreprises émergentes du moyen de motiver leur personnel ;

- la lourdeur et le coût considérables de l’adaptation à la loi Sarbanes-Oxley empêcheront pratiquement les entreprises émergentes d’entrer en bourse, c’est-à-dire d’accéder aux sources de capital (notons que les éventuelles entreprises émergentes françaises n’auront pas à souffrir un tel dommage, puisque l’accès au marché boursier leur est déjà pratiquement impossible) ;

- cette fermeture du marché boursier aux entreprises émergentes casse le modèle américain de capital-risque, sur lequel reposait la créativité industrielle du pays ;

- les analystes financiers optimistes, accusés d’entraîner les épargnants dans des aventures dangereuses, risquent désormais la prison : on peut s’attendre à une flambée de pessimisme ;

- l’orientation des entreprises selon les nouveaux impératifs de réduction des coûts et d’optimisation des achats coupe court à toute tentation d’innover.

Hutcheson est d’autant plus sévère à l’égard de la nouvelle législation que, selon lui, les lois existantes étaient tout-à-fait suffisantes pour assurer la transparence et lutter contre la fraude.

J’ajouterais que ces différentes législations souffrent (à mon humble avis) d’un vice de conception : elles suggèrent que la comptabilité des entreprises pourrait résulter de l’observation neutre et objective de phénomènes naturels, un peu comme les sciences de la nature, alors qu’un système comptable est construit avec des objectifs et des intentions.

Sans se prononcer sur le bien-fondé de l’analyse de Hutcheson, force est de constater l’expansion considérable de la bureaucratie dans l’activité économique contemporaine. Max Weber avait déjà analysé son caractère inéluctable (la bureaucratie serait un peu comme l’entropie, une quantité qui ne diminue jamais). La forme actuelle de cet essor bureaucratique est le pouvoir croissant des milieux financiers.

Conclusion (hypothétique)

Qu’a-t-il manqué à l’industrie japonaise pour consolider sa position dominante de la fin des années 1980 ? Les entrepreneurs japonais maîtrisaient, et maîtrisent encore, tous les aspects techniques des processus décrits ci-dessus, sans doute mieux que leurs concurrents américains d’ailleurs.

Des entreprises géantes comme NEC, Fujitsu ou Hitachi ne pouvaient être arrêtées ni par des obstacles financiers, ni par des obstacles techniques. Elles avaient sans aucun doute la capacité de concevoir de nouveaux types de processeurs, mais pas celle de les imposer sur le marché, et ce, en tout cas c’est mon hypothèse, parce qu’elles n’étaient pas en situation de produire et d’imposer sur le marché le système d’exploitation qui aurait permis de les mettre en œuvre. Si elles savaient concevoir des processeurs conformes à l’état de l’art du moment (et elles en sont toujours capables), elles ne connaissaient le succès qu’en restant dans la ligne en cours de cet état de l’art, cependant que dans ce domaine les conceptions novatrices couronnées de succès ont presque toutes été américaines.

Dans le domaine du logiciel la créativité demande une certaine anarchie, de la liberté d’idées, elle est incompatible avec une organisation sociale autoritaire et hiérarchique. La création d’un logiciel aussi complexe et aussi gros qu’un système d’exploitation demande qu’au sein de cette anarchie il y ait de l’organisation, que la liberté d’idées accepte un but commun. Bref, le mariage de l’expression et de l’abnégation est un équilibre difficile, pour l’analyse duquel l’étude de l’exemple Linux serait d’ailleurs un exercice éclairant ; chaque cas est particulier, se prononcer sur les cas japonais ne m’est pas possible. Ce qui est sûr c’est que l’obstacle n’était ni technique ni financier.

La proximité géographique, sociale et intellectuelle entre les équipes qui développent le matériel et celles qui développent le système peut être importante : quand Gary Kildall a commencé à développer CP/M, il faisait son service militaire à quelques kilomètres des labos. d’Intel. Bill Joy a créé Sun à côté de Berkeley où il avait été un des auteurs de BSD. Multics s’est créé au MIT, tout près de GE.

Les Japonais ont créé ou adapté à leurs propres architectures matérielles (NEC notamment) des systèmes complexes, de même que des équipes françaises ont pu créer d’excellents systèmes (GCOS 7, Prologue), sans oublier les Britanniques d’ICL (aujourd’hui rachetés par Fujitsu). Ces systèmes n’ont jamais vraiment percé en dehors de leur pays d’origine. Lorsqu’une entreprise cliente s’engage sur la voie d’un système d’exploitation, si ce n’est pas pour des décennies, cela ne vaut pas la peine : alors il faut que l’auteur du système soit crédible pour des décennies, et la meilleure preuve, c’est encore qu’il fasse cela depuis des décennies. Les Japonais (comme les Français) n’apparaissaient pas comme des gens vraiment enracinés dans un terreau culturel comparable à celui du MIT ou de Berkeley.

En conclusion, les industries américaines dans les domaines des semi-conducteurs et des systèmes informatiques détiennent le monopole de la conception et de l’innovation, et rien ne permet de prédire la fin de ce monopole dans les prochaines années. Cette maîtrise repose sur toute une culture scientifique et technique qui s’est élaborée au long de décennies, dans des dizaines d’universités et de laboratoires, c’est-à-dire que de nouveaux entrants ne peuvent pas espérer se l’approprier rapidement. Comme ces activités sont aussi celles qui conduisent l’économie mondiale, on peut dire que les États-Unis détiennent ainsi une arme décisive pour faire face à la menace du déclin.

L’Europe ne peut pas en dire autant, malgré les résultats très honorables de son industrie des semi-conducteurs représentée par Infineon, STMicroelectronics et Philips. En effet, si ces firmes sont bien placées du point de vue du volume, on ne peut pas en dire autant si l’on examine les conceptions novatrices de pointe dans le domaine des processeurs destinés à l’informatique.